活到老,学到老。

一、引入

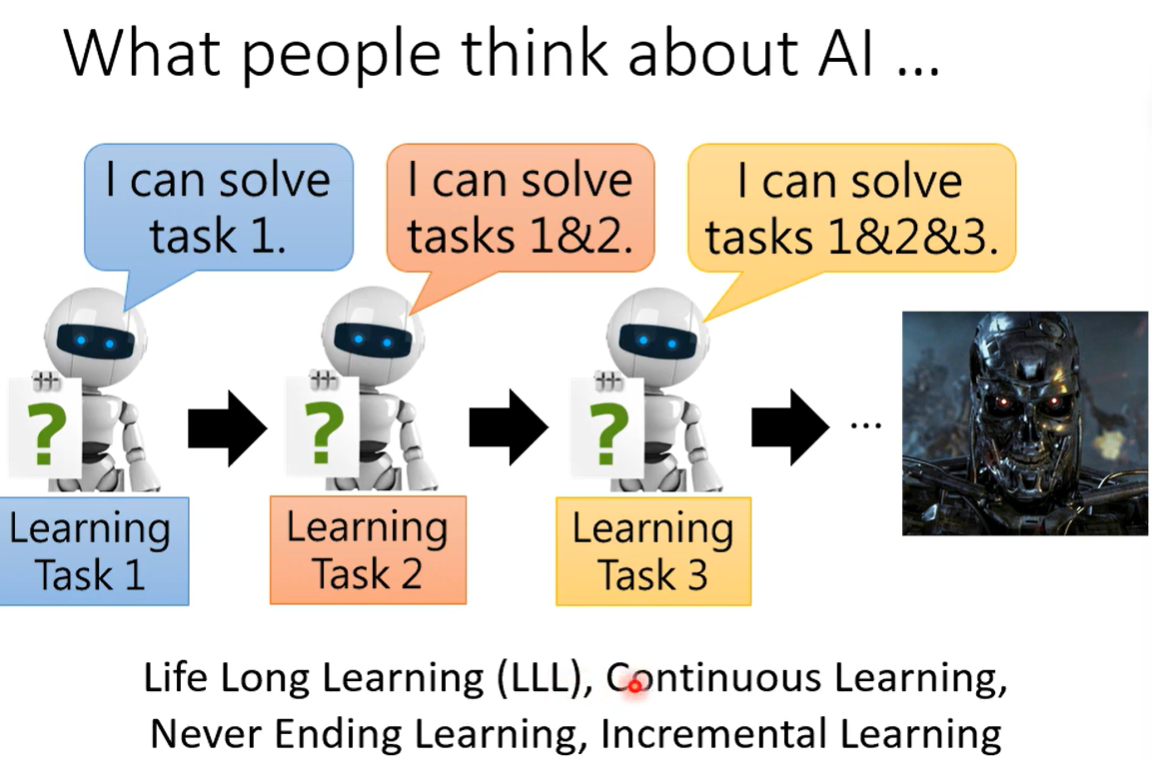

不断教授机器新的技能,从而完成终极机器。

二、LLL的难点

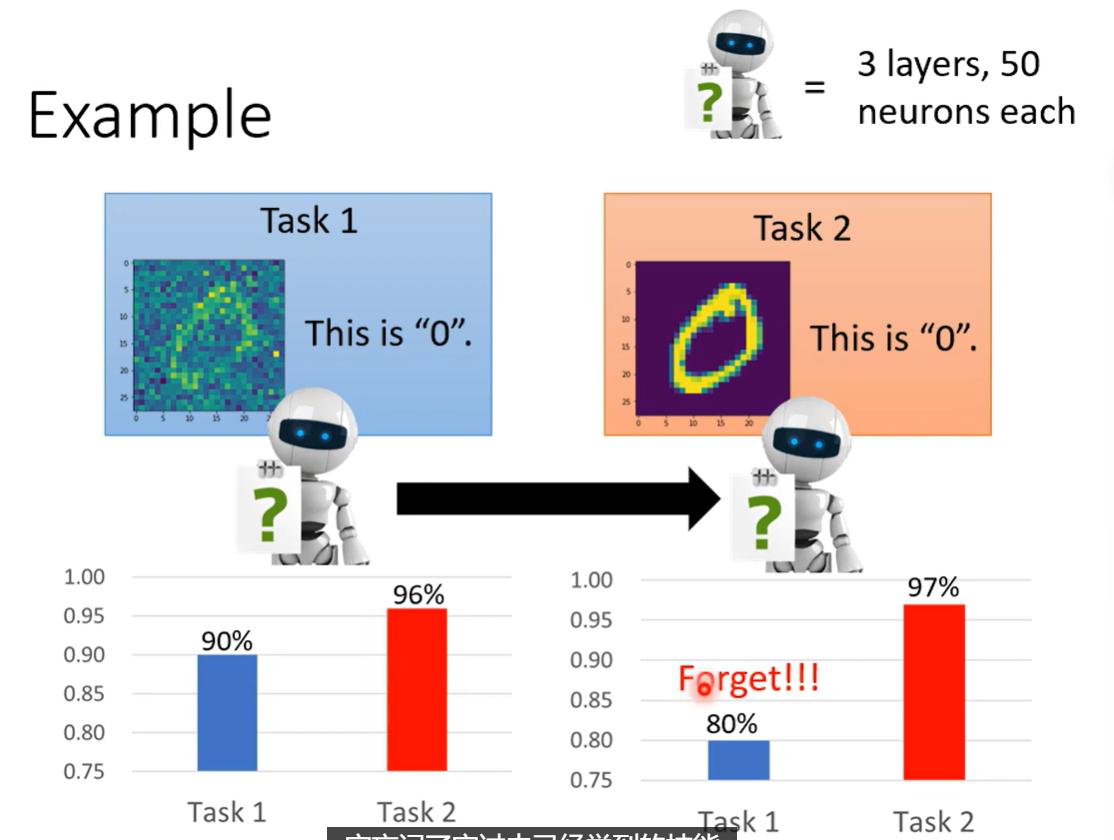

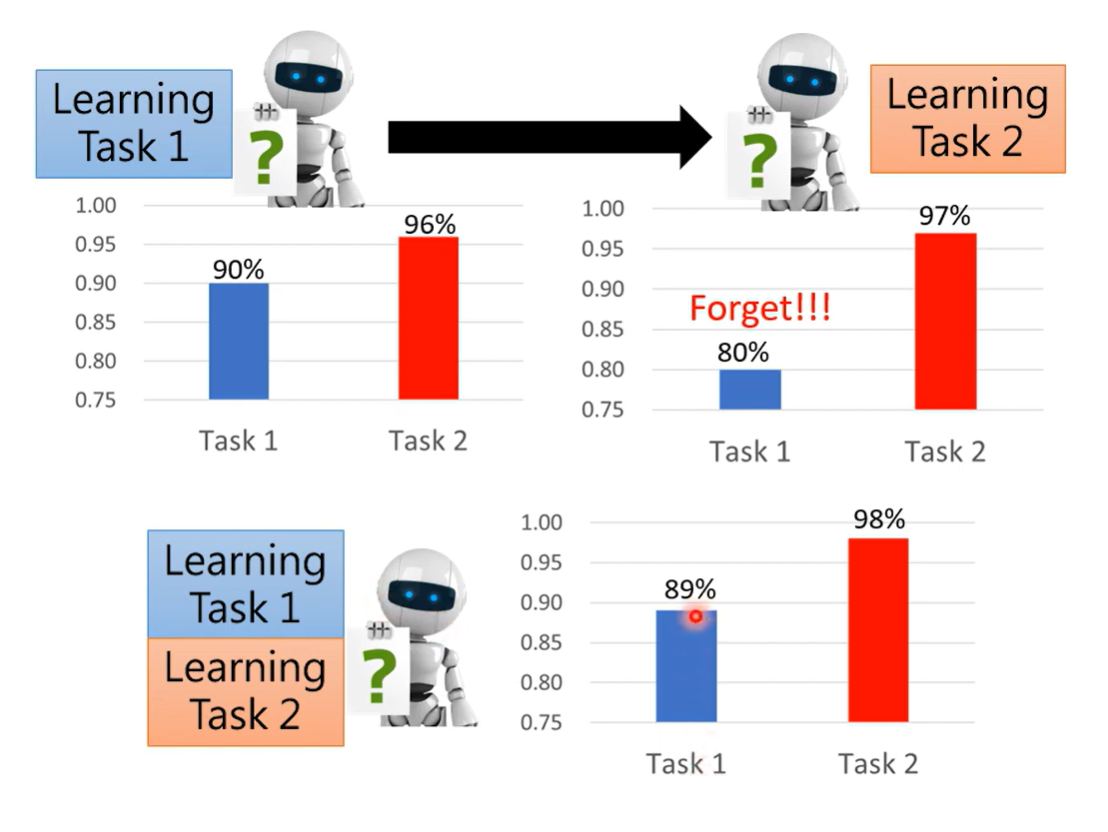

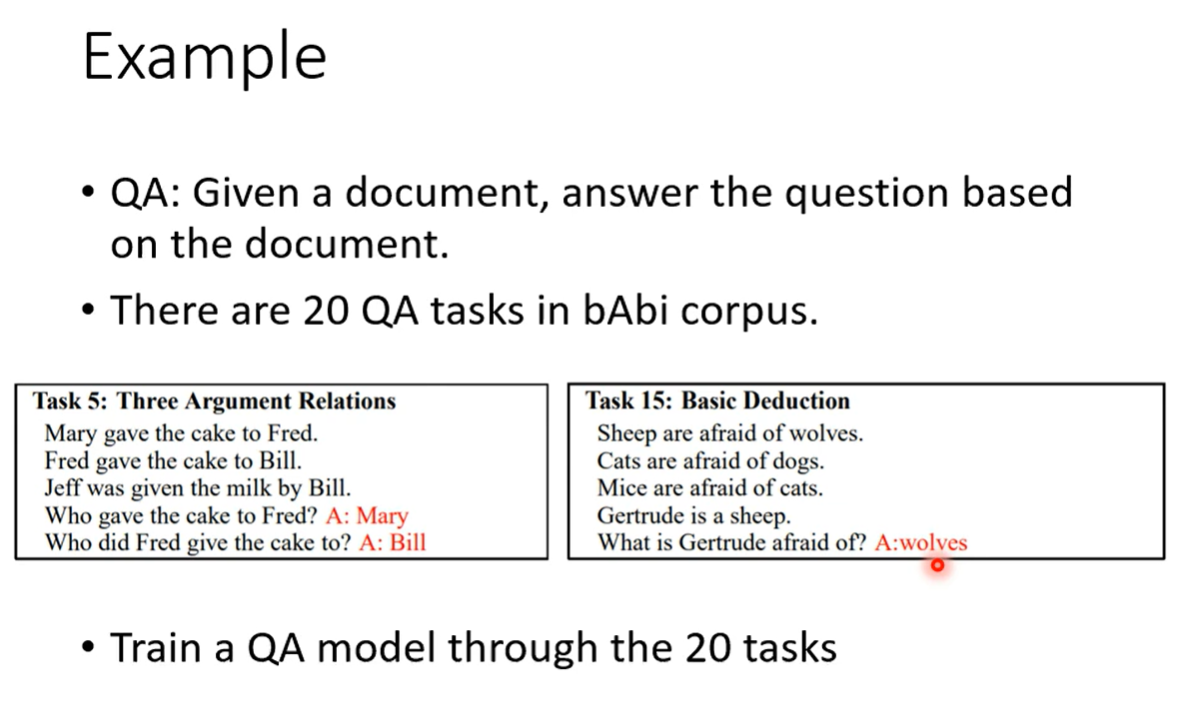

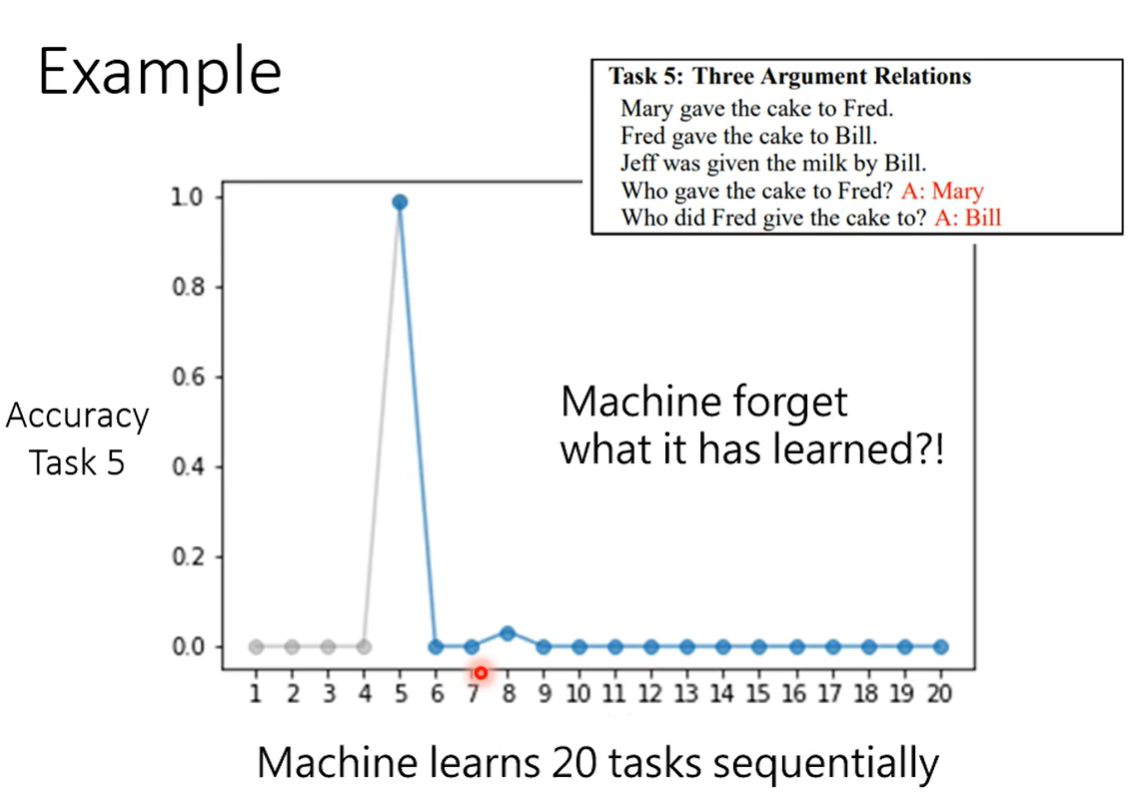

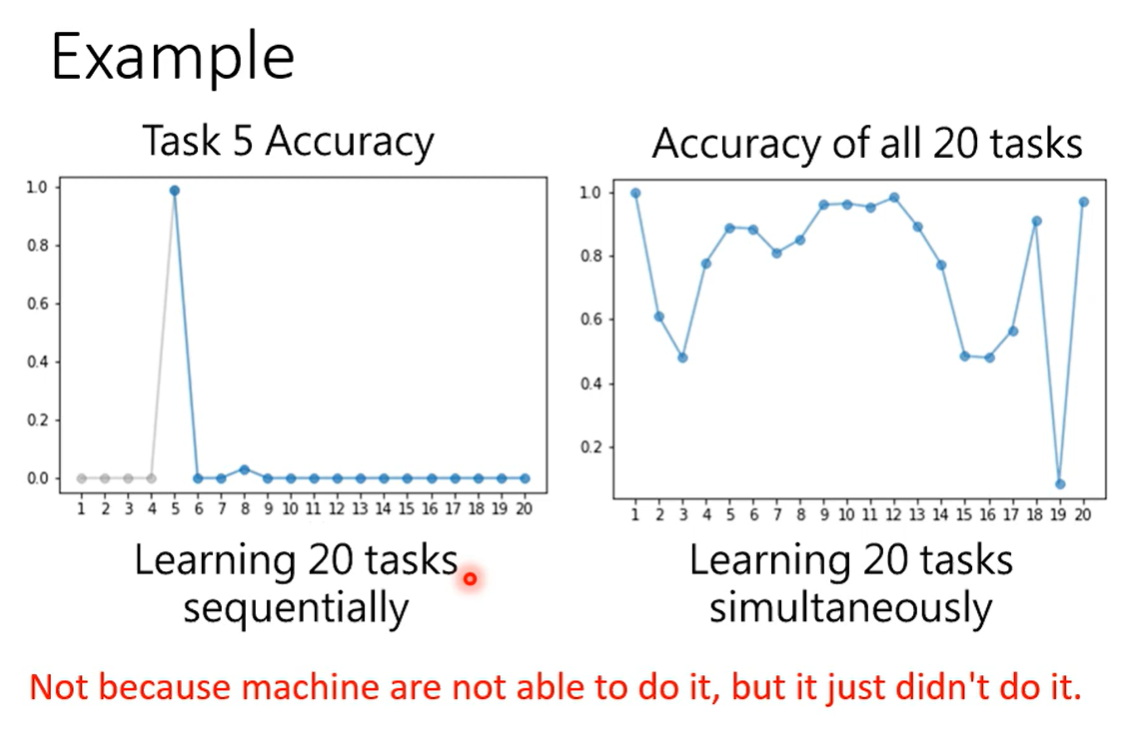

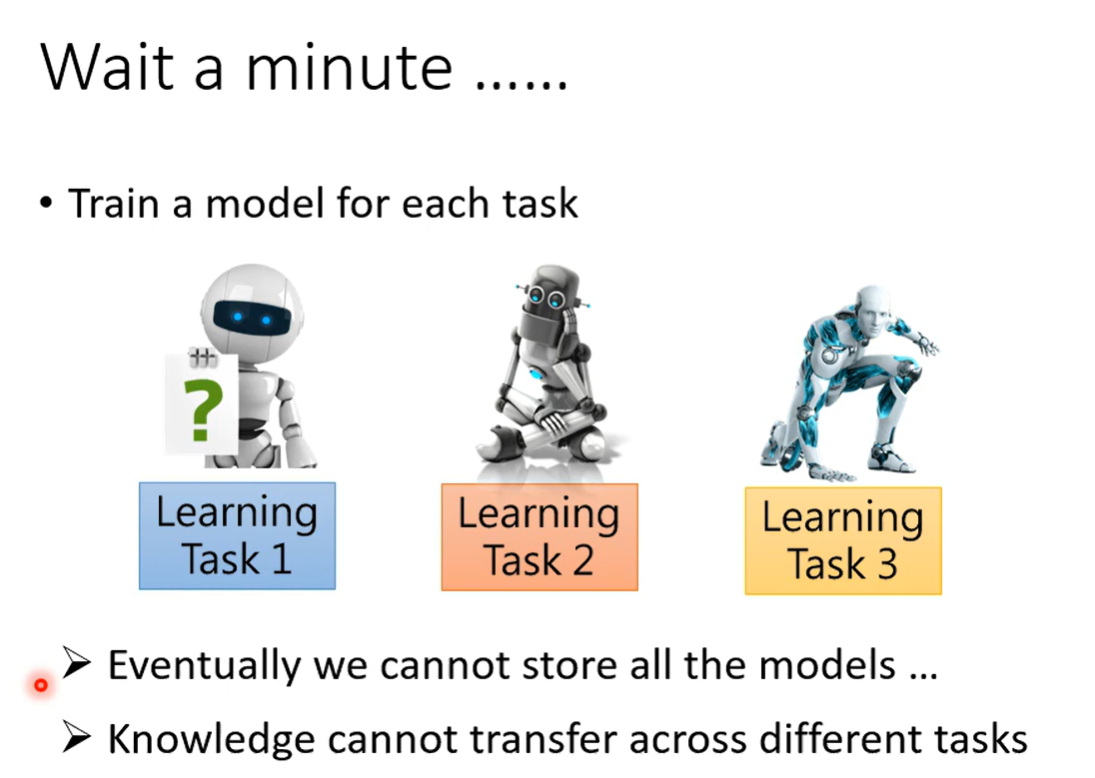

Catastrophic Forgetting 灾难性遗忘

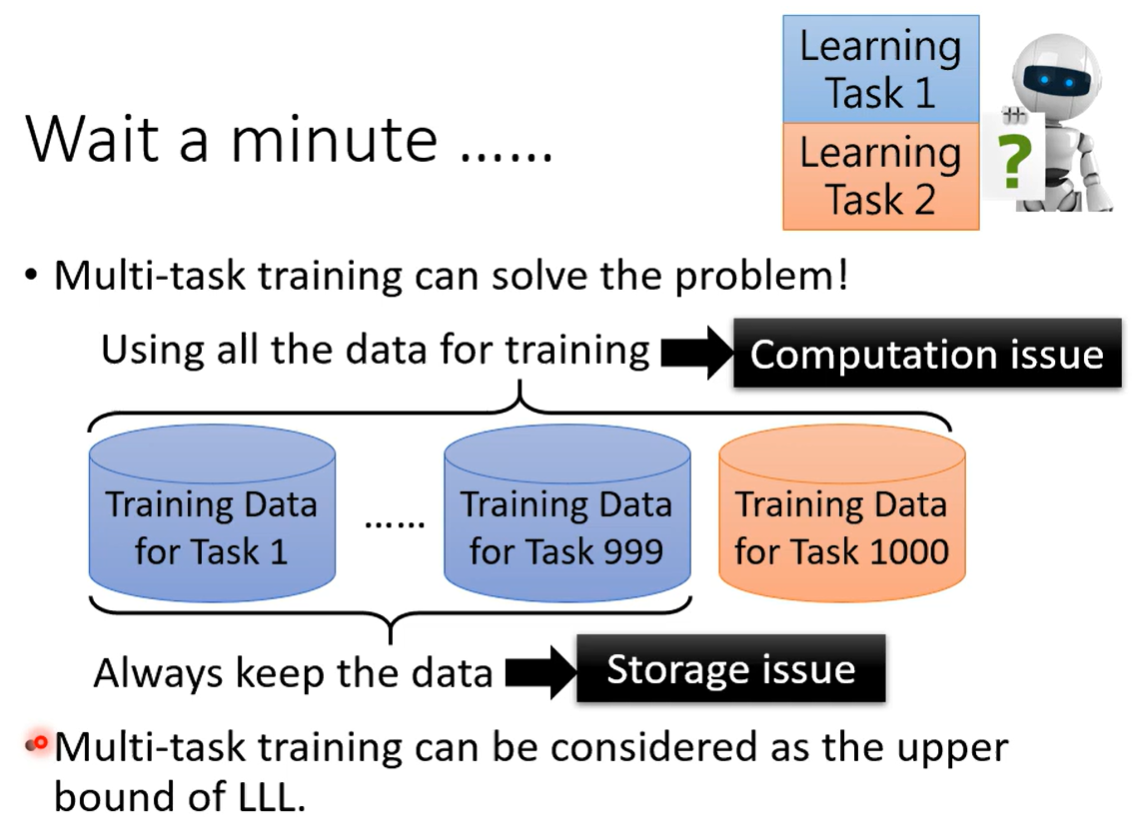

多任务训练的上限是LLL要去逼近的结果。

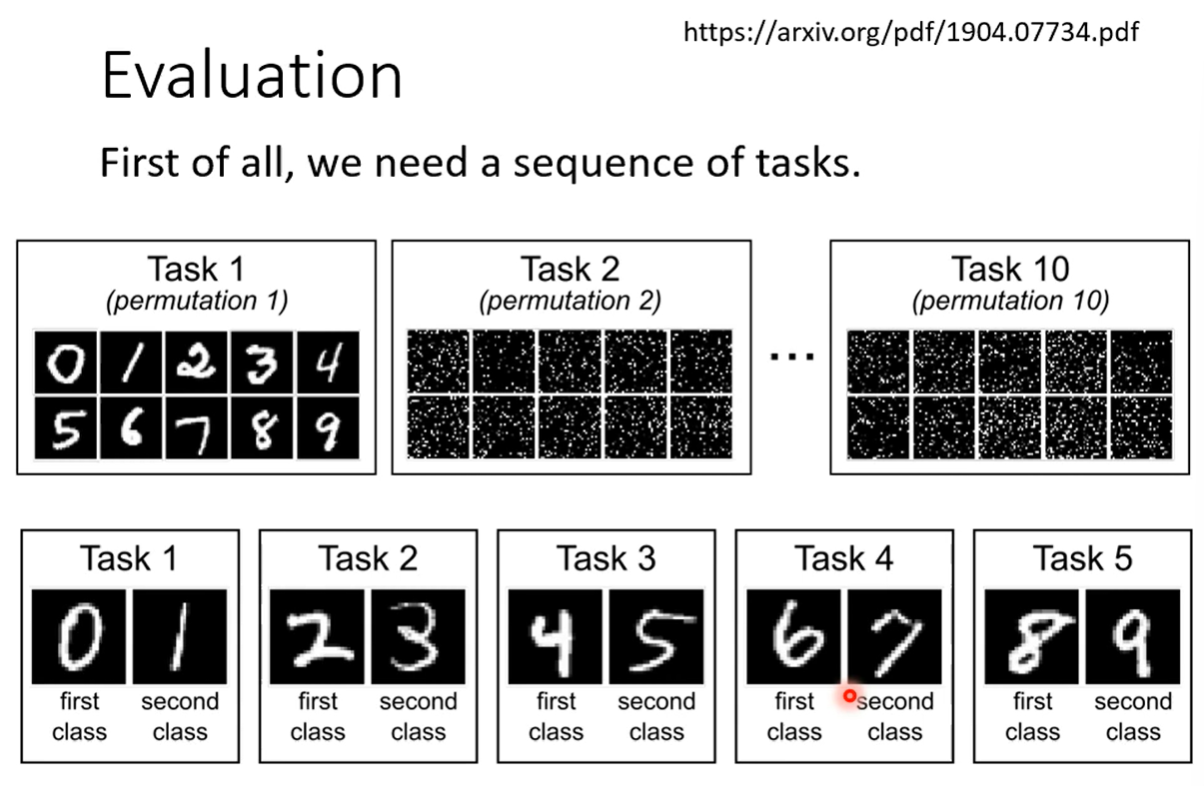

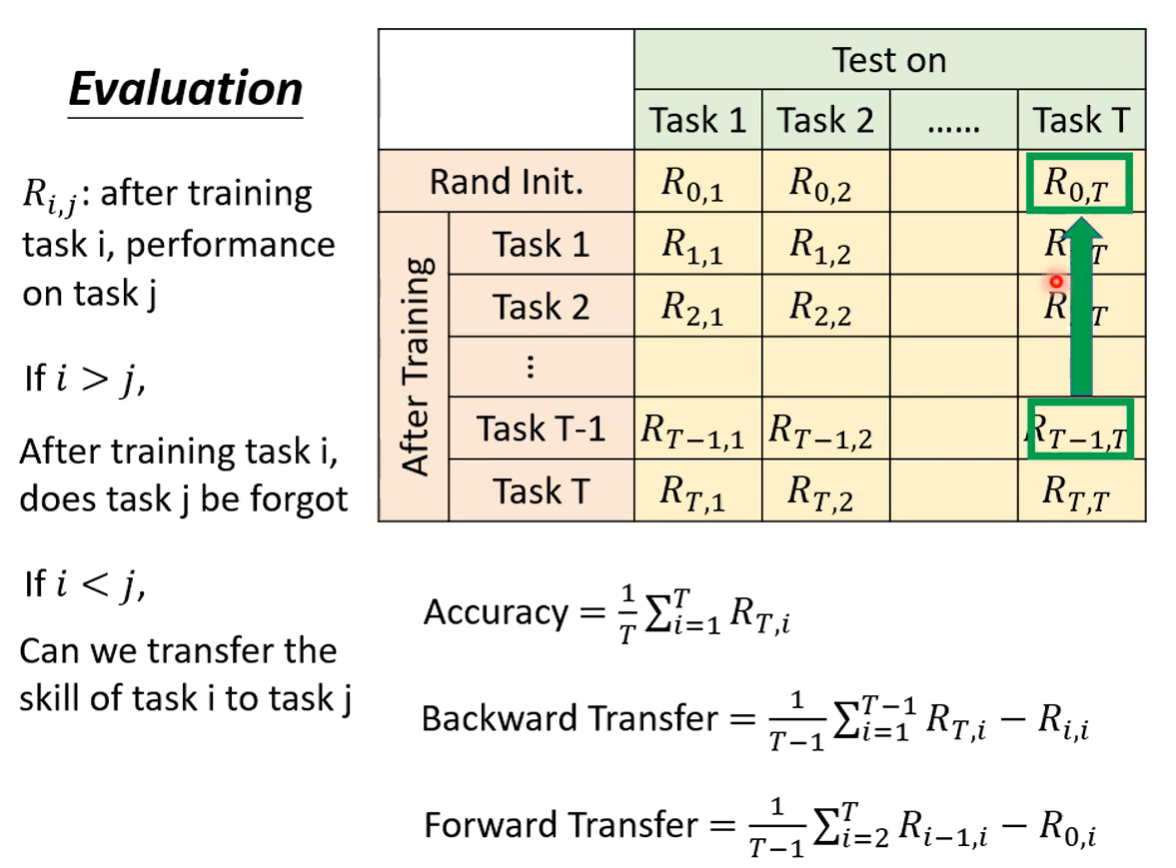

三、LLL的评估

准确率

向后转变

向前转变

四、LLL的解法

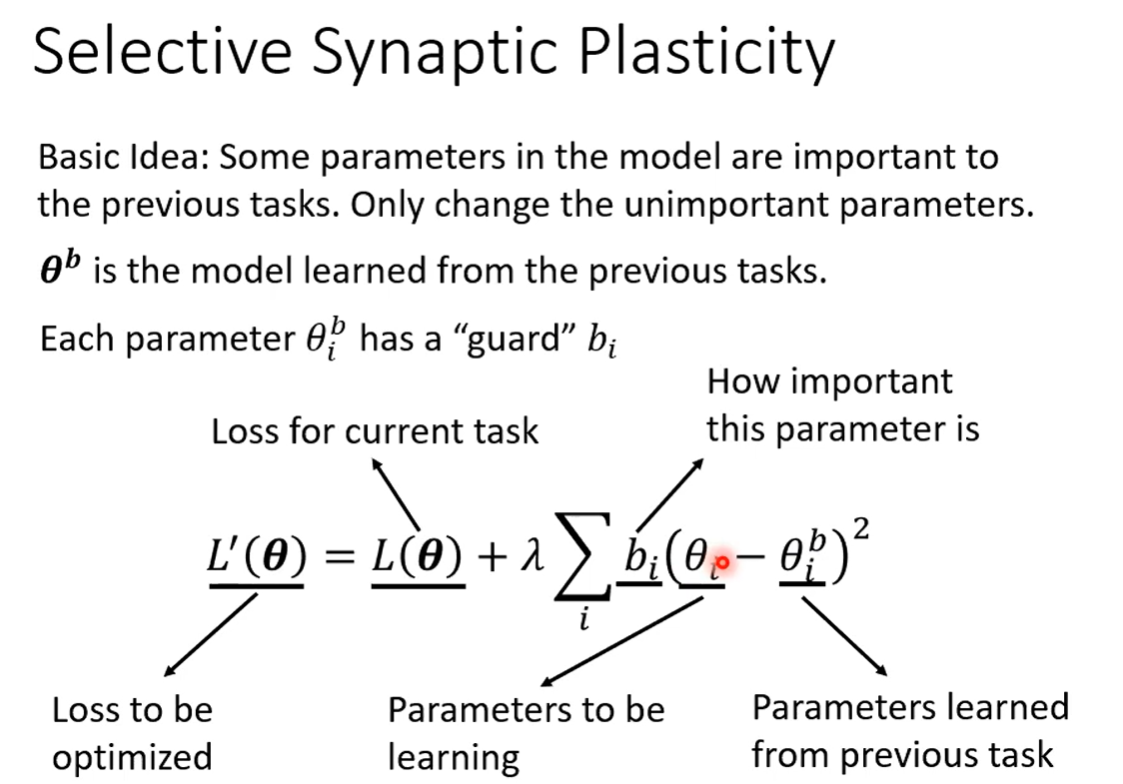

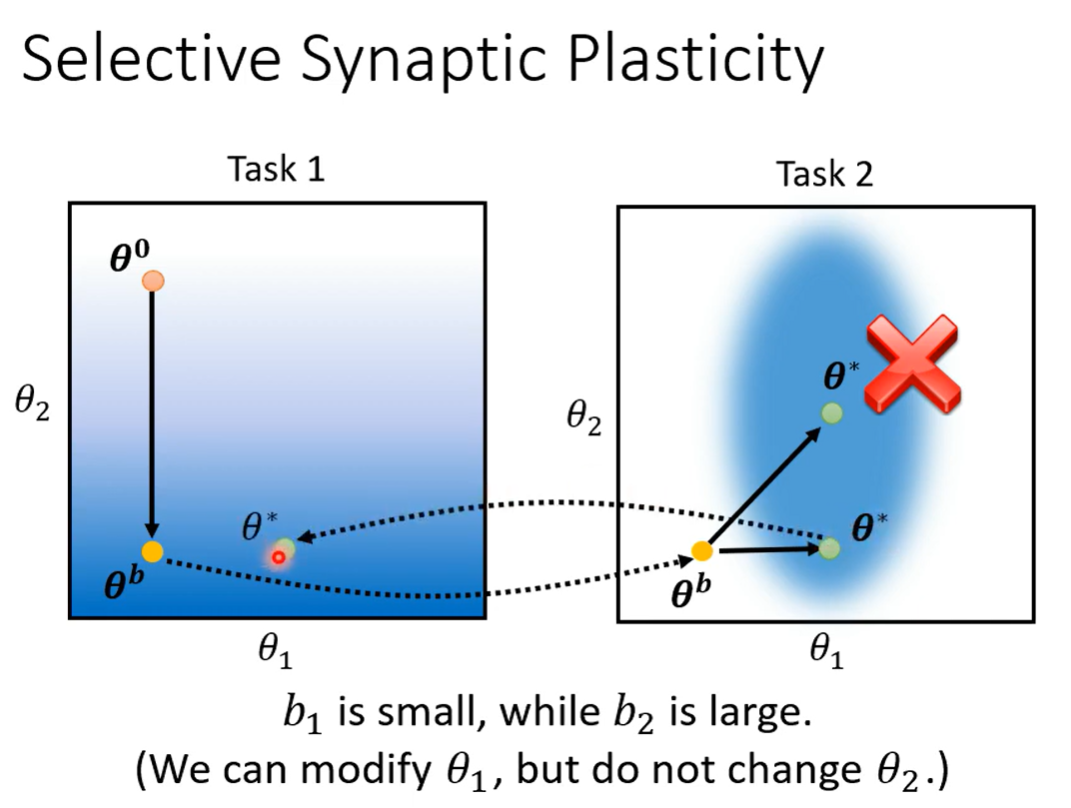

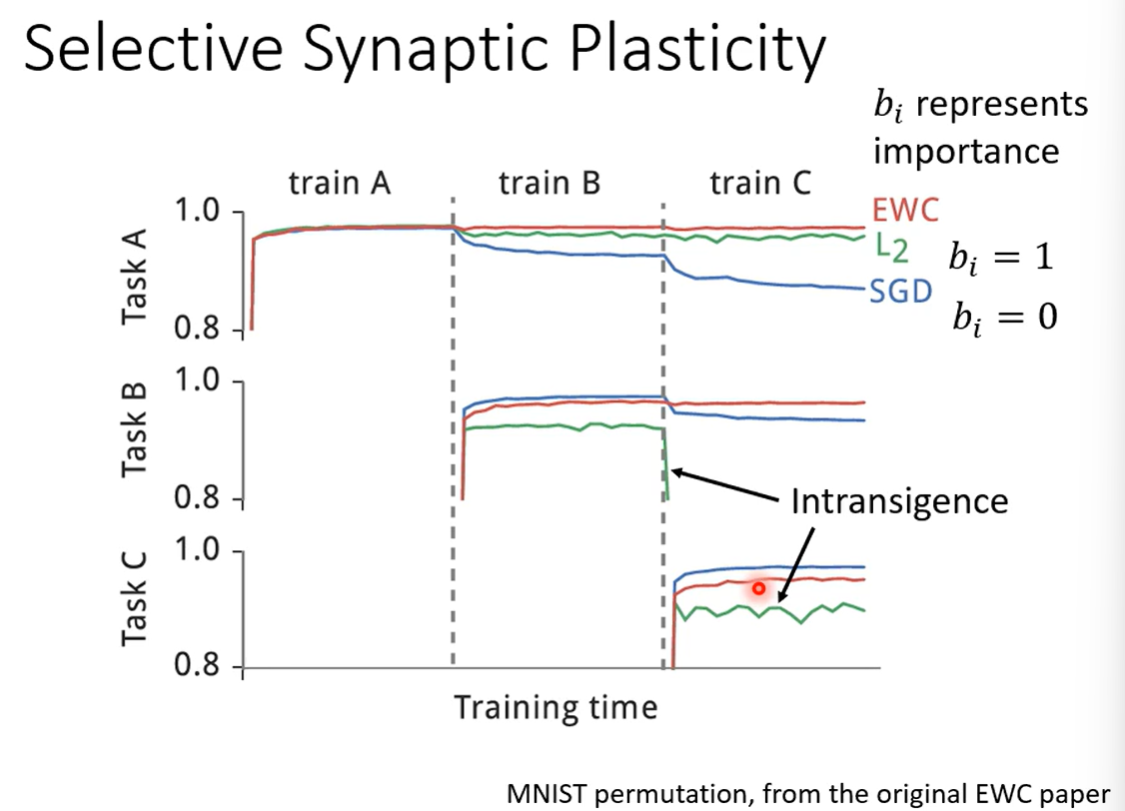

4.1 Selective Synaptic Plasticity

部分可塑神经突触(基于正则化的方法)。

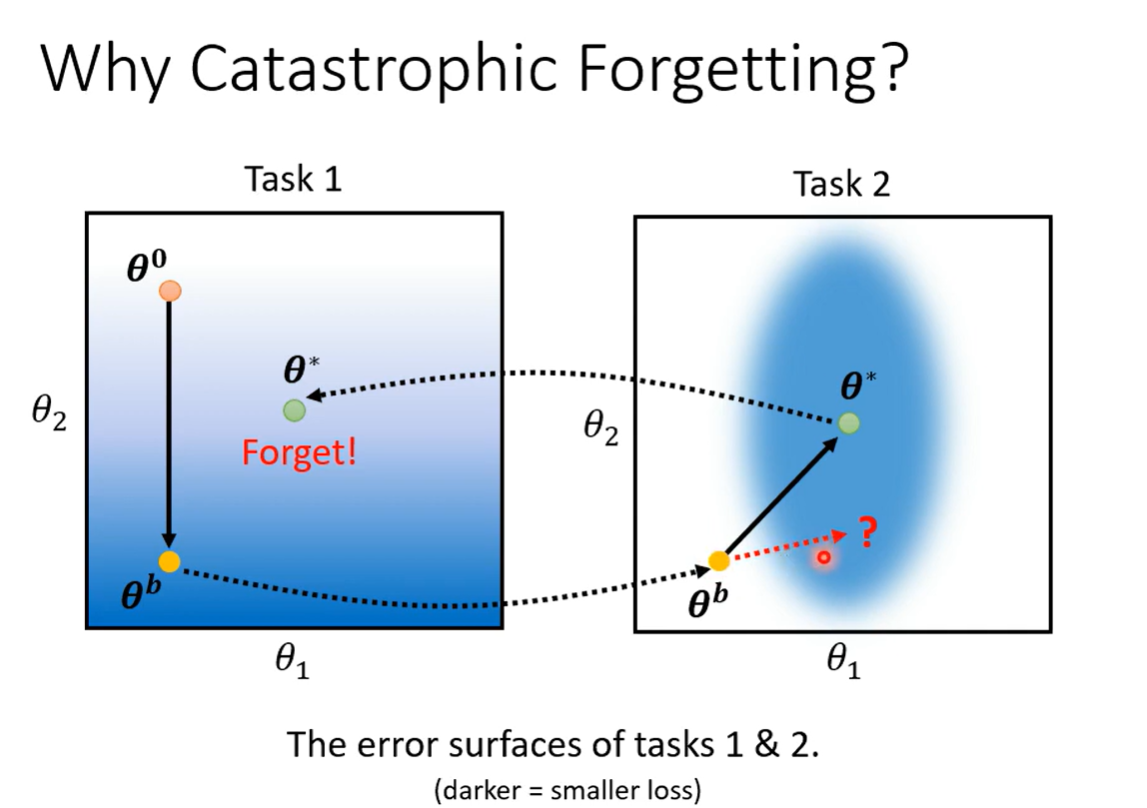

为什么会灾难性遗忘?

颜色越偏蓝色,loss越小。

越白,Loss越大。

在损失函数上加上一项,正则化项。

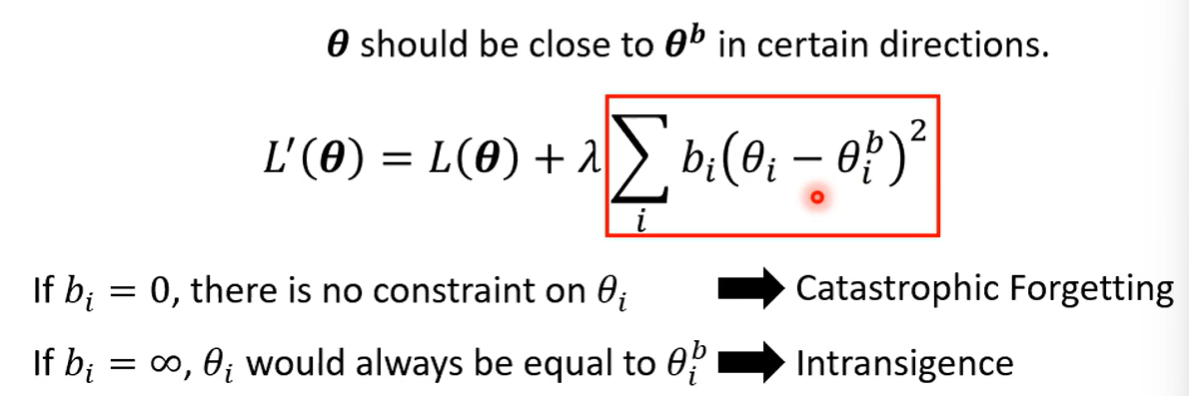

bi设置为0是不好的。

bi设置为很大也是不好的。

要么忘的太多,要么一点不学新的。

bi不能是学习出来的,因为会直接趋近于0,使得这一项为0。所以要认为设置。

做法:

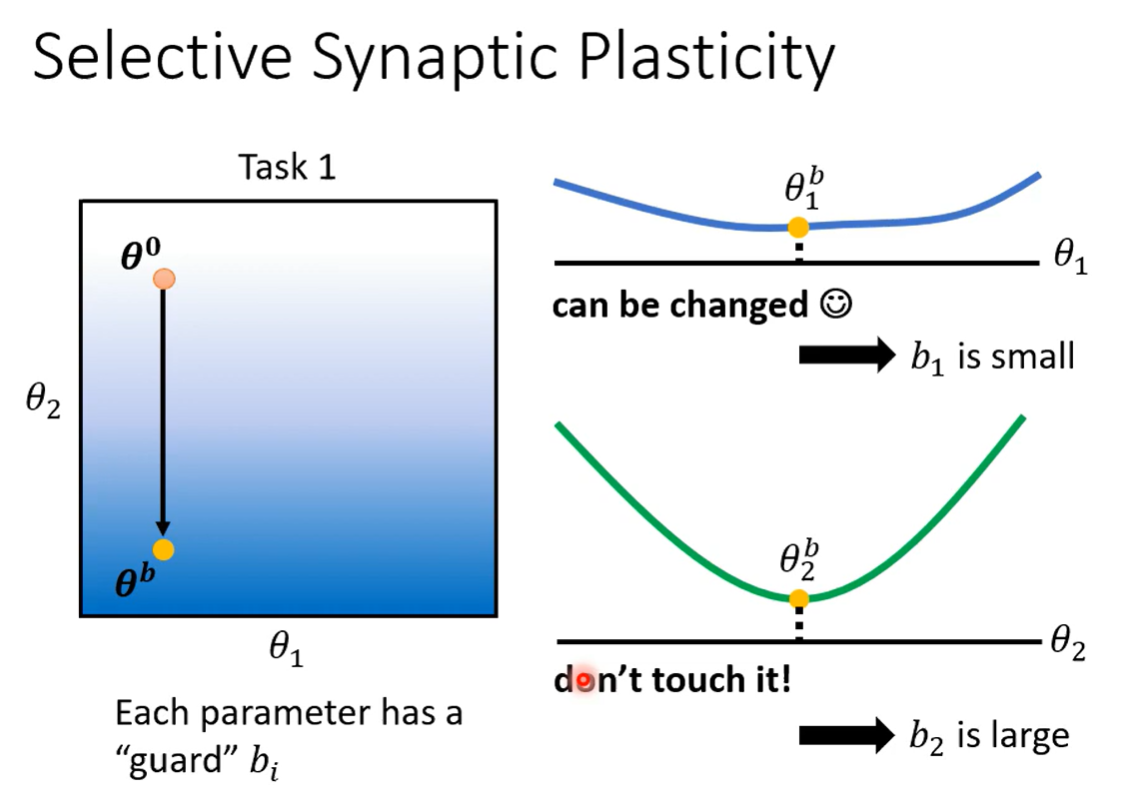

如果改变一个参数的值改变Loss 的程度很小,那么这一个参数相当于不重要,所以设置的bi也要小一点。

反之。

bi的越大代表了这个参数的变化应该较小。

而bi的小值代表了这个参数可以较大变化。

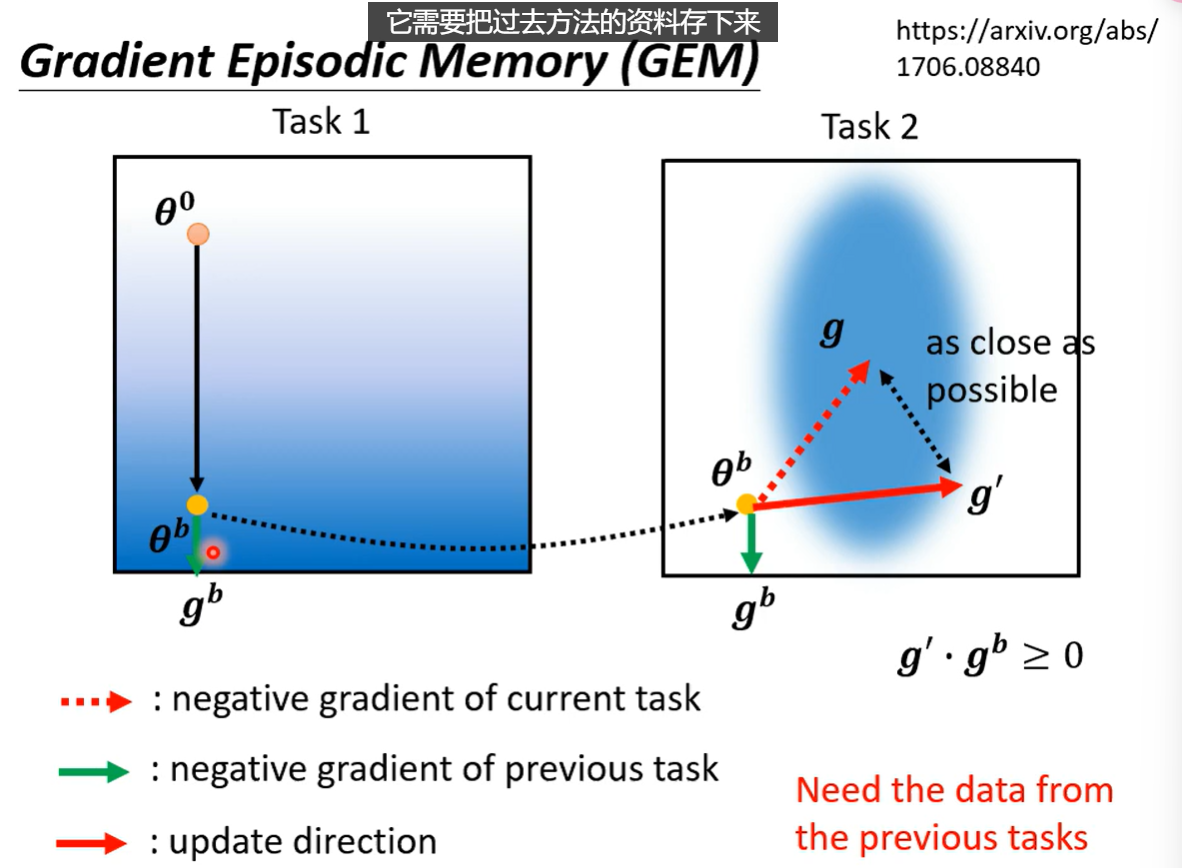

GEM:

限制梯度下降的方向。

缺点:存取过去的资料。(少量)

但是之前的方法也备份了一个相同的参数,也会占用一定的空间。

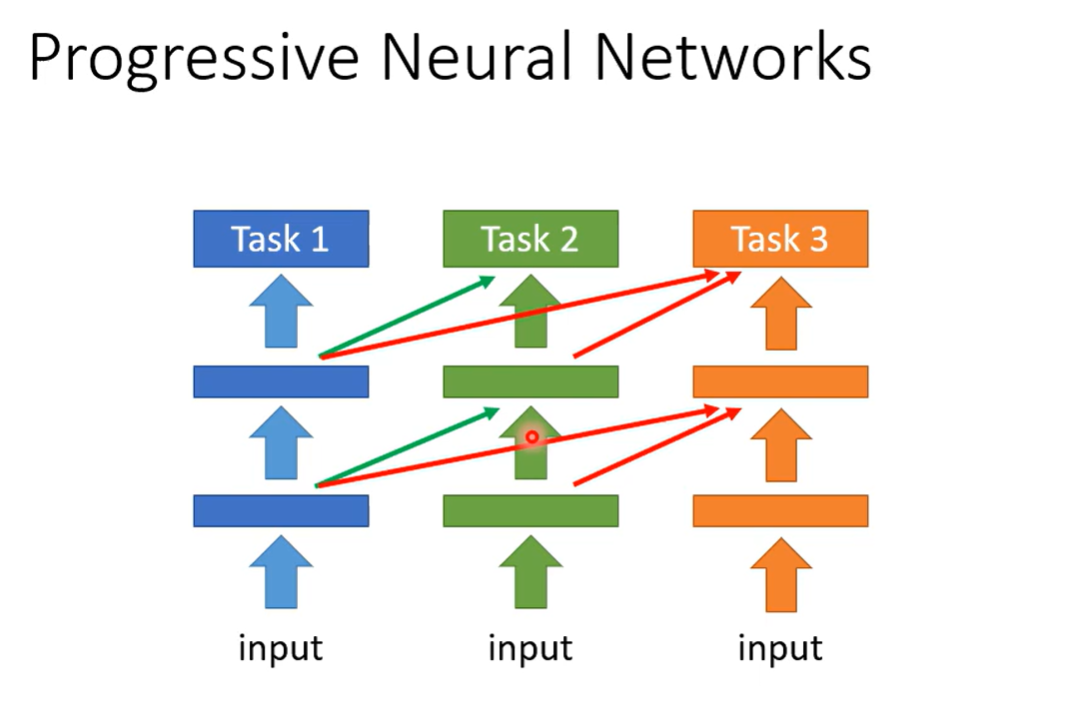

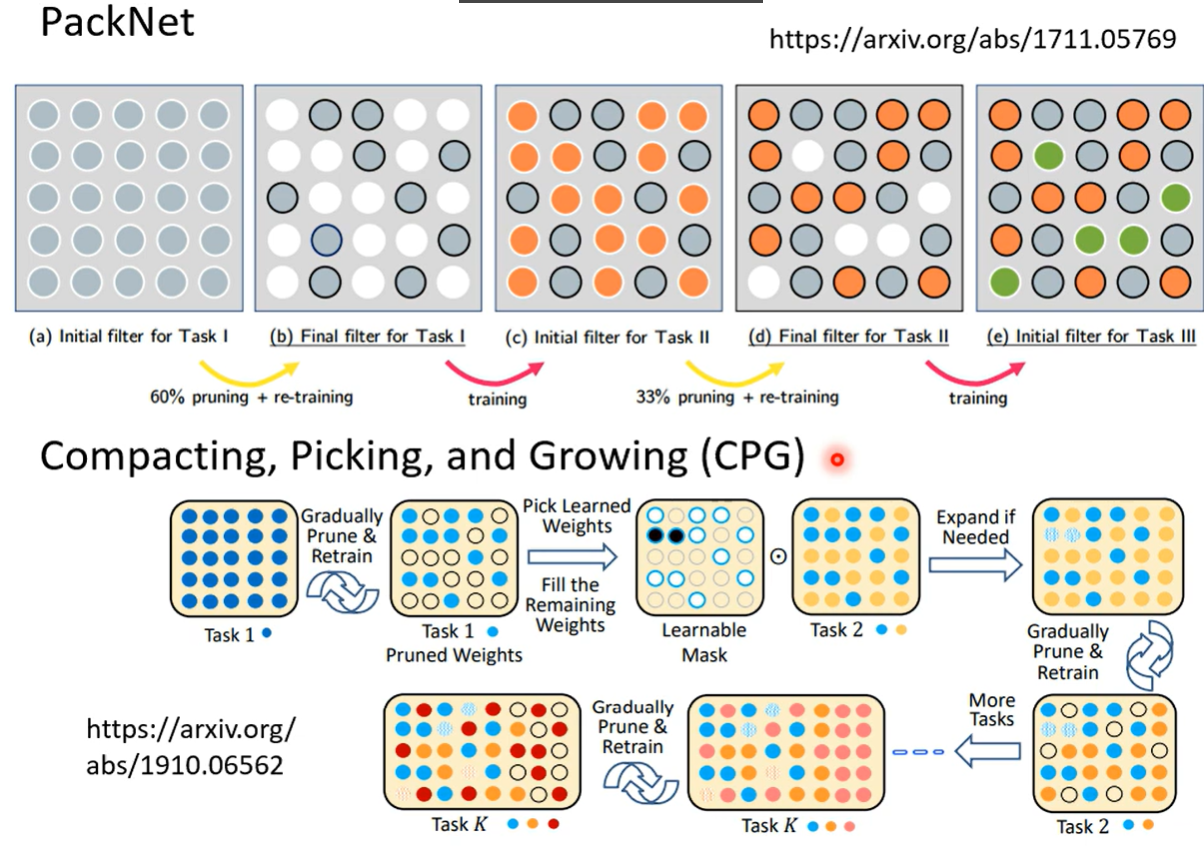

4.2 Additional Neural Resource Allocation

开辟额外的空间在新的任务上学习。

旧的网络保持不变。

先开一个大的NN。

针对与不同的任务使用不同的参数。

CPG将上边结合。可以增加也可以减少。

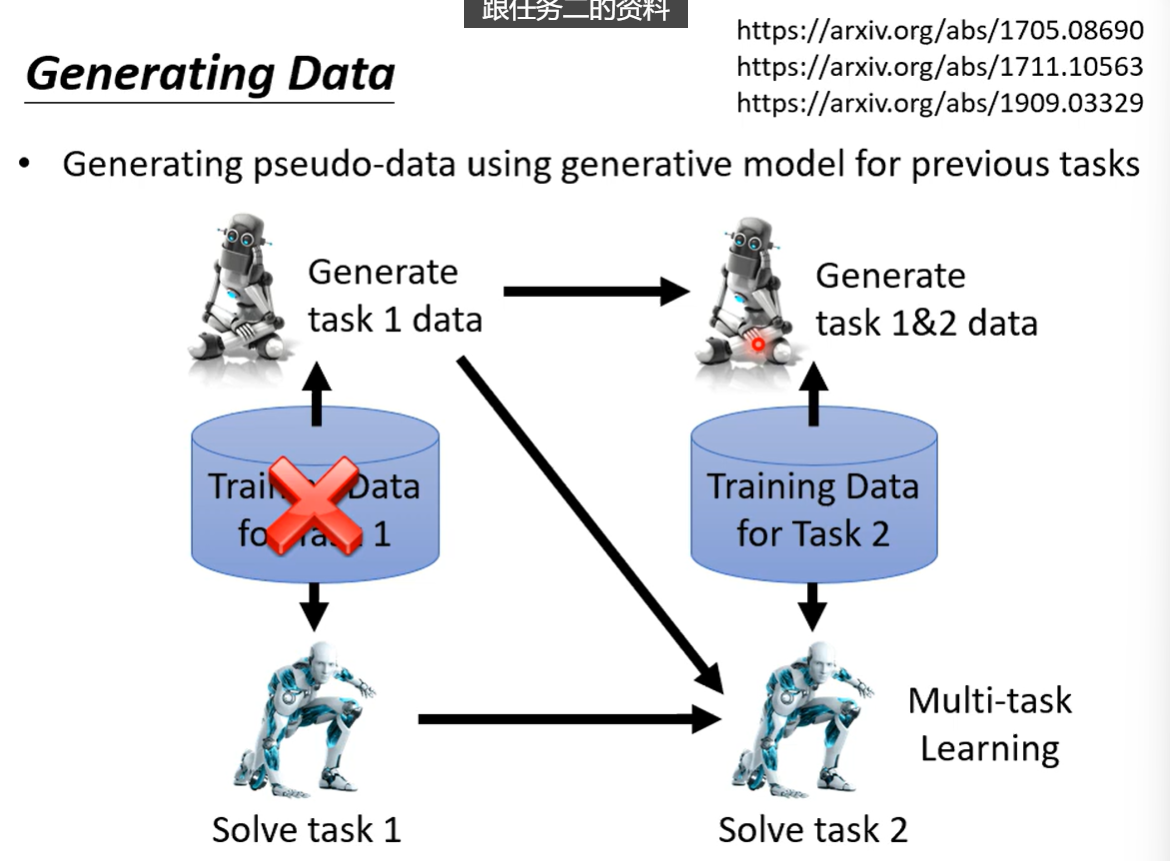

4.3 Memory Reply

不存放过去的数据,不仅训练一个任务解决网络,而且训练一个生成网络,生成之前的数据,进行新的认为训练。

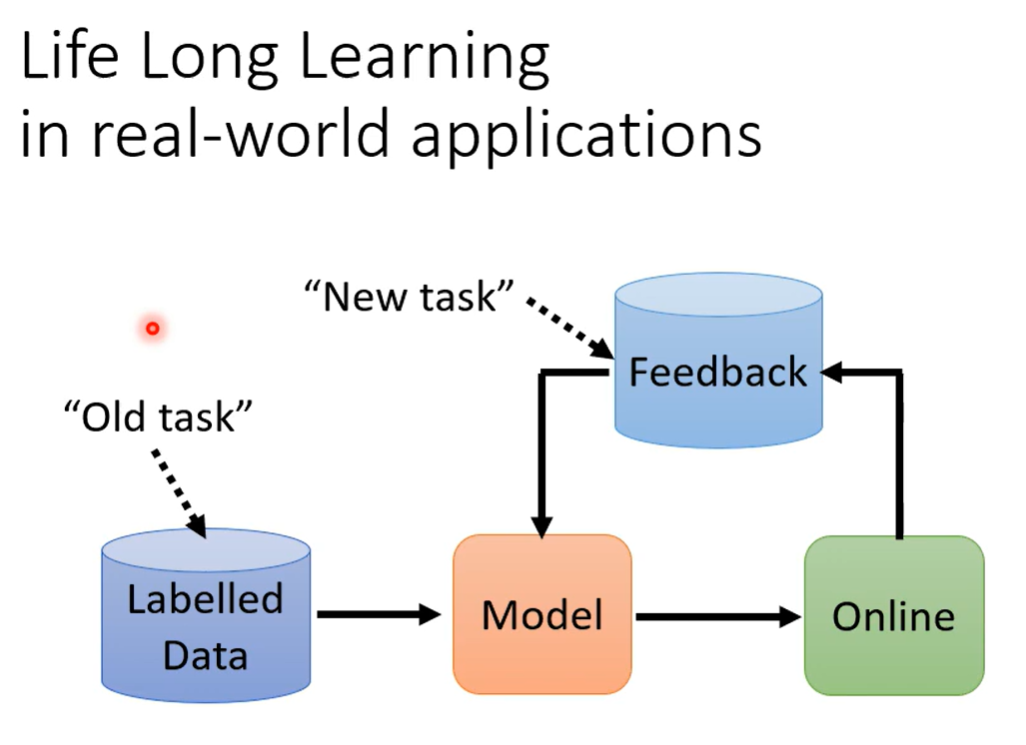

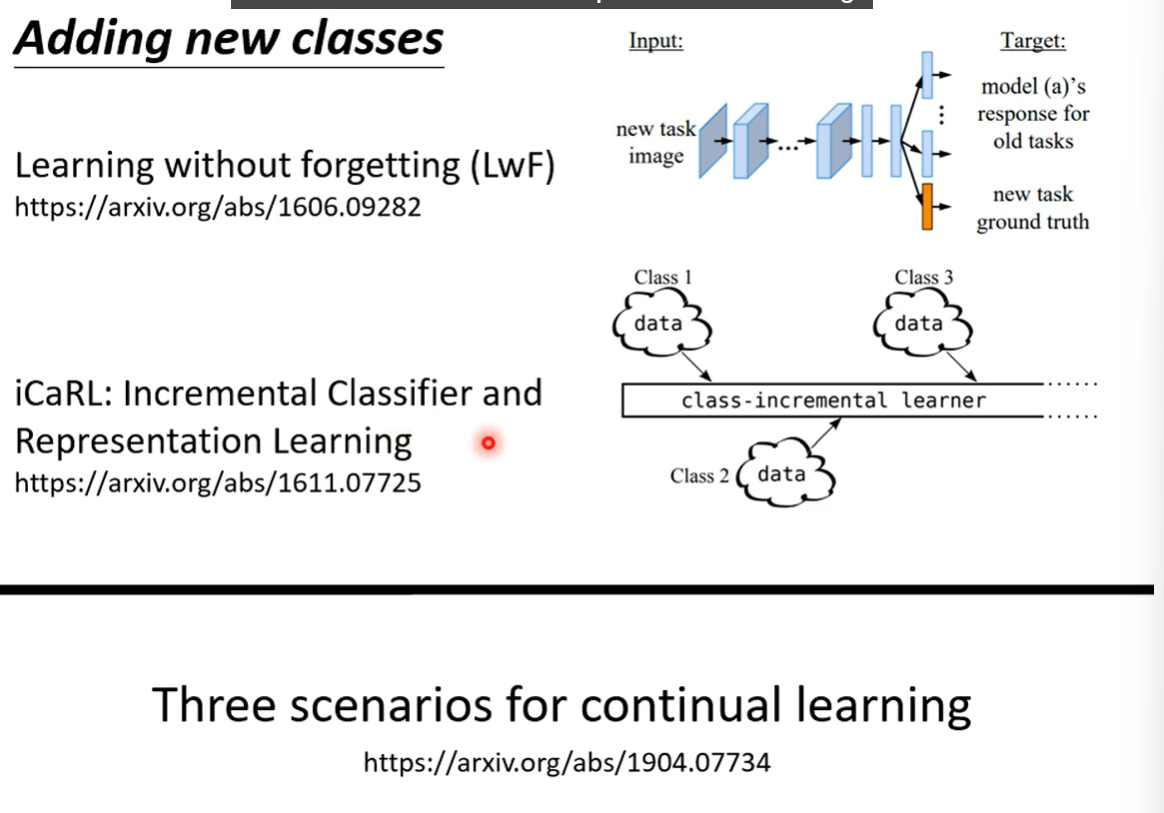

五、LLL的新问题

训练的输出类不一定一致。

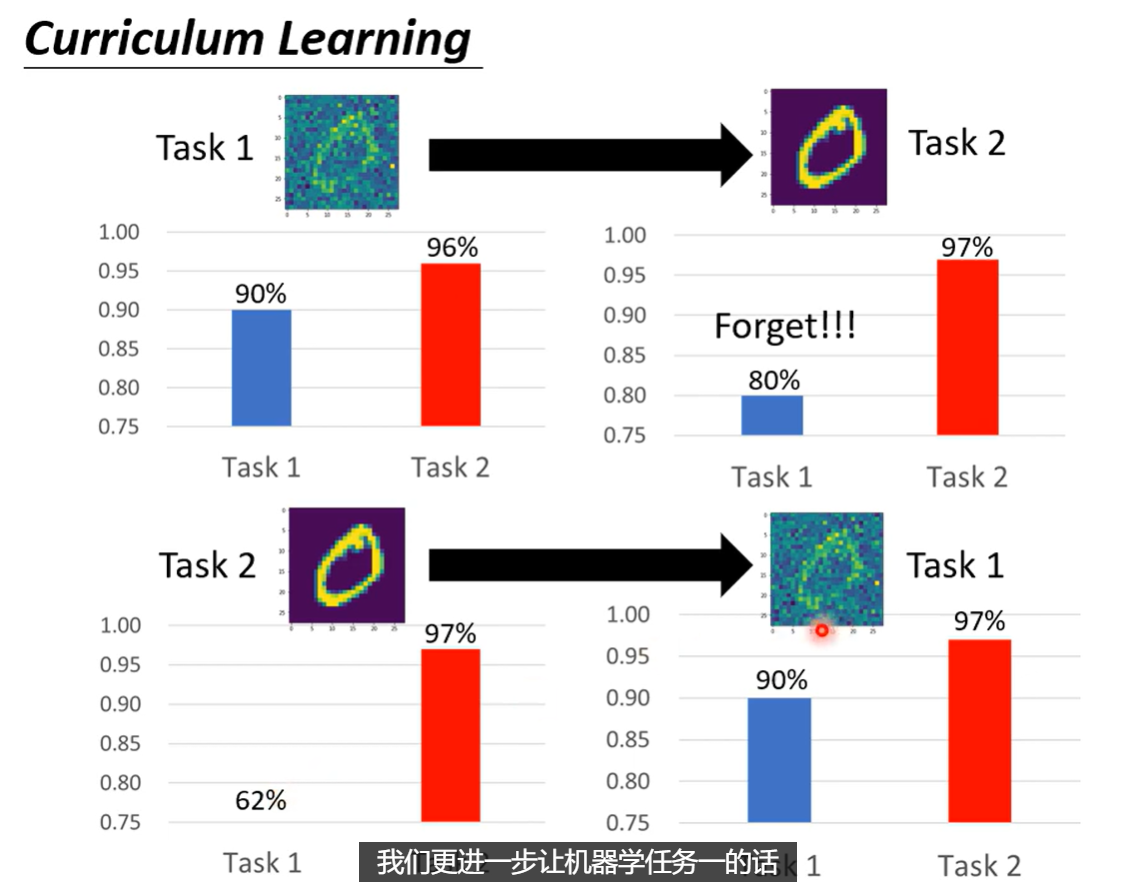

调换任务学习的顺序也会影响LLL。